我是靠谱客的博主 懦弱信封,这篇文章主要介绍java.lang.NoClassDefFoundError: org/apache/hadoop/hbase/HBaseConfiguration,现在分享给大家,希望可以做个参考。

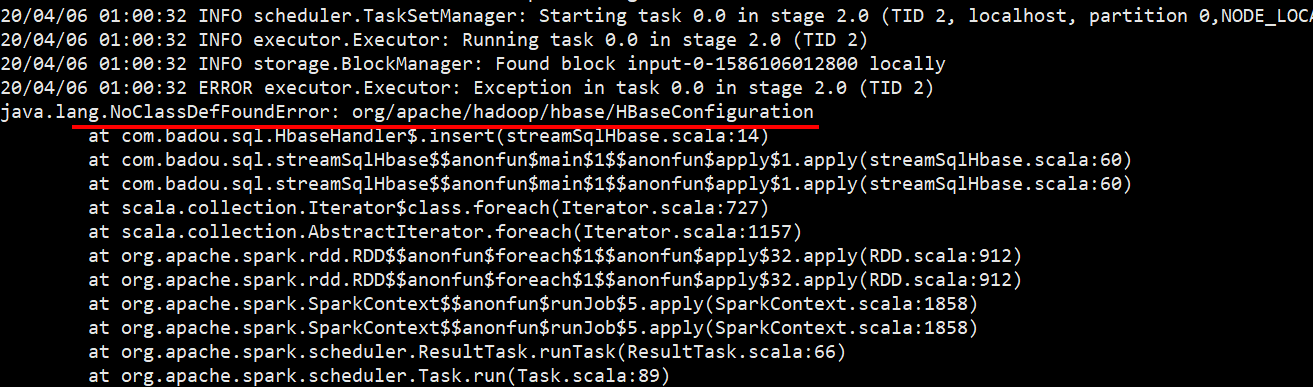

IDEA打包Spark-HBase程序时缺少jar包,把spark submit到集群中运行时报错:

Exception in thread “main” java.lang.NoClassDefFoundError: org/apache/hadoop/hbase/HBaseConfiguration

at SparkHbase

解决办法:

1、在hadoop安装目录下找到hadoop-env.sh文件

添加 :

export HADOOP_CLASSPATH=$HADOOP_CLASSPATH:/usr/local/src/hbase-0.98.6-hadoop2/lib/*

/usr/local/src/hbase-0.98.6-hadoop2 为自己的hbase安装路径

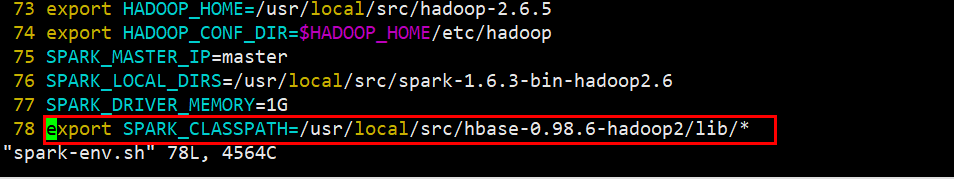

2、在spark安装路径的conf文件夹找到spark-env.sh

添加 :

export SPARK_CLASSPATH=/usr/local/src/hbase-0.98.6-hadoop2/lib/*

/usr/local/src/hbase-0.98.6-hadoop2 为自己的hbase安装路径

source spark-env.sh

重新提交spark服务,问题解决!

最后

以上就是懦弱信封最近收集整理的关于java.lang.NoClassDefFoundError: org/apache/hadoop/hbase/HBaseConfiguration的全部内容,更多相关java.lang.NoClassDefFoundError:内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复