信息量I与消息出现的概率 P(x) 之间的关系:

1.信息量是概率的函数,即I=f[P(x)];

2.P(x) 越小,I越大,P(x) 越大,I越小;

3.若干个相互独立事件构成的消息,所含信息量等于各独立事件信息量之和,信息量具有相加性。

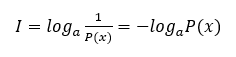

信息量的计算公式如下:

其中,a=2时,单位为比特(bit);

a=e时,单位为奈特(nit);

a=10时,单位为哈莱特。

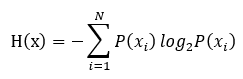

当消息很长时,用符号出现概率来计算消息的信息量是比较麻烦的,此时可以用平均信息量的概念来计算,所谓平均信息量是指每个符号所含信息量的统计平均值,因此N个符号的离散消息的平均信息量:

上述平均信息量计算公式与热力学和统计力学中关于系统熵的公式一样,因此我们也把信源输出消息的平均信息量叫做信源的熵。

下面来通过一个例题加深印象。

例:某离散信源由0,1,2,3四个符号组成,它们出现的概率分别是3/8,1/4,1/4,1/8,且每个符号的出现都是独立的。试求消息序列:201020130213001203210100321010023102002010312032100120210的信息量。

解答如下:

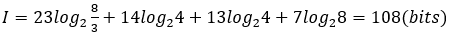

此消息共有57个符号,其中,0出现了23次,1出现了14次,2出现了13次,3出现了7次。

该消息的信息量计算如下:

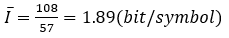

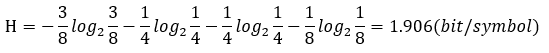

从而每个符号的平均信息量为:

若用平均信息量(信源的熵)来计算:

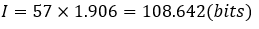

则该消息的信息量为:

这个例题到此就解答完毕了。

希望以上内容对你有帮助!

最后

以上就是仁爱灯泡最近收集整理的关于离散信源信息量、平均信息量的计算的全部内容,更多相关离散信源信息量、平均信息量内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复